- Arquitetura e Cloud

Data Quality está no centro das decisões de grandes organizações como consequência da transformação digital, do uso de analytics e BI e, claro, da Inteligência Artificial.

Não à toa: iniciativas de IA, automação e produtos digitais só são tão boas quanto os dados que as alimentam. Bad data, por sua vez, compromete modelos analíticos, distorce insights, gera retrabalho e expõe sua empresa a riscos regulatórios e reputacionais.

E, como você deve imaginar, isso pode custar milhões por ano às organizações.

Ao mesmo tempo, a pressão por compliance, especialmente com legislações como a LGPD, elevou o nível de exigência sobre controle, rastreabilidade e confiabilidade dos dados. Data Quality, mais uma vez, aparece como um pilar do uso de dados e IA.

Vamos ver, então, como o conceito de Data Quality pode ser usado para alcançar maturidade corporativa conectando tecnologia, governança e resultados de negócio.

Data Quality (qualidade de Dados) refere-se à capacidade de um conjunto de dados atender ao seu propósito previsto, sendo confiável, consistente e apropriado para análises e decisões de negócio.

Quando falamos em qualidade de dados, não estamos lidando com um atributo único, mas com um conjunto de características que, combinadas, determinam se os dados podem ou não ser utilizados com segurança.

Entre os principais atributos de Data Quality, destacam-se:

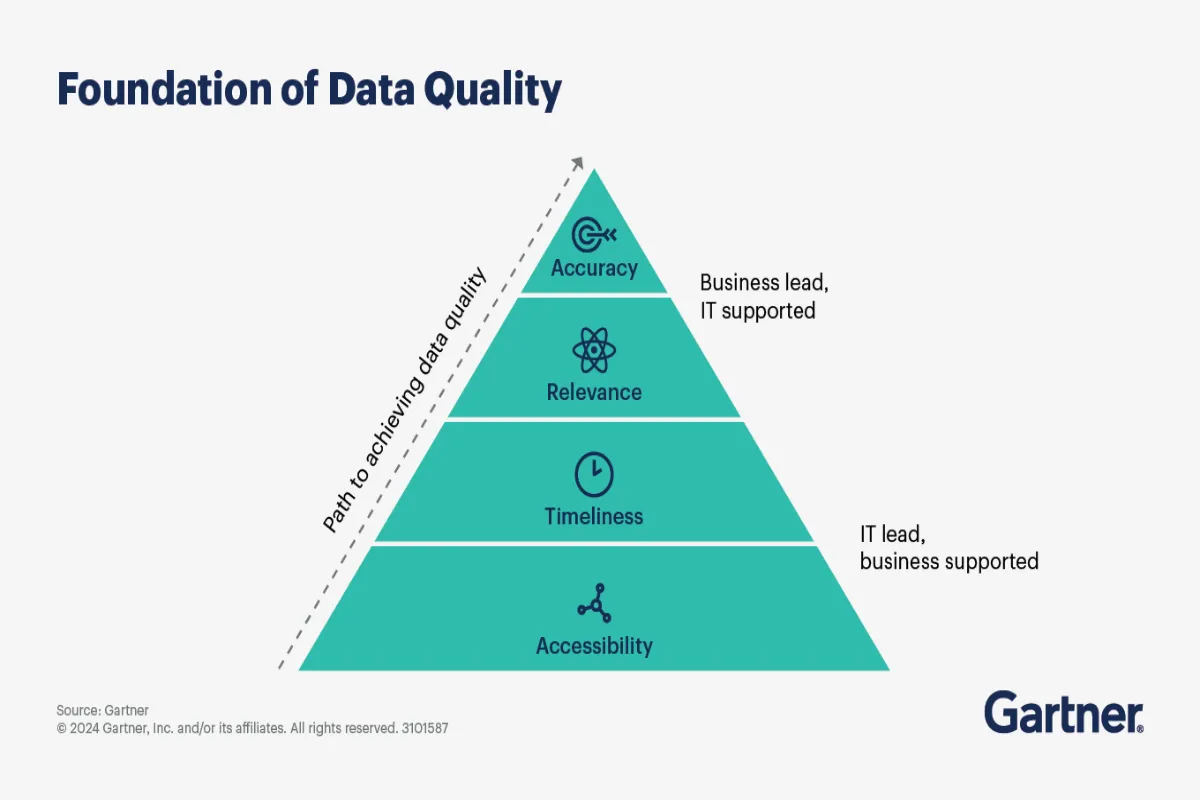

Veja como isso se constrói de maneira lógica dentro de uma empresa:

Fonte: Gartner

Quando atende a esses critérios, o conjunto pode ser classificado como “dados com qualidade”. Isso significa que o time pode contar com informações adequadas para a análise de dados, geração de insights, automação de processos e uso em modelos analíticos e de IA.

A qualidade dos dados é fundamental para decisões estratégicas, análises de BI (Business Intelligence), modelos de Inteligência Artificial e operações corporativas confiáveis.

Dados inconsistentes ou incompletos podem distorsionar relatórios, enviesar modelos analíticos, gerar retrabalho e expor a organização a riscos regulatórios e reputacionais.

Entenda melhor nos tópicos abaixo.

Empresas orientadas por dados dependem de informações confiáveis para alimentar dashboards de BI, análises avançadas e modelos de Inteligência Artificial.

Por outro lado, dados inconsistentes ou incompletos levam a relatórios distorcidos, modelos enviesados e decisões equivocadas, o que compromete iniciativas estratégicas inteiras.

Organizações com alta maturidade em Data Quality conseguem explorar dados de forma mais sofisticada. Nesse sentido, viabilizam inovação em produtos digitais, personalização de experiências e novos modelos de negócio.

O custo da má qualidade de dados se manifesta em diversas frentes. Por exemplo:

Além disso, ambientes com dados fragmentados e sem padronização elevam o custo de integração e manutenção de sistemas.

Políticas claras, papéis bem definidos e processos de controle ajudam a mitigar riscos operacionais, financeiros e regulatórios. Ainda mais, com a Lei Geral de Proteção de Dados Pessoais (LGPD) já vigente há alguns anos.

Dessa maneira, dados imprecisos, desatualizados ou sem rastreabilidade aumentam a exposição da empresa a sanções, auditorias e danos reputacionais.

Atingir e sustentar altos níveis de Data Quality ainda é um desafio para muitas organizações porque os obstáculos são tecnológicos e também organizacionais, culturais e operacionais.

Grandes empresas operam com múltiplos sistemas, plataformas e fornecedores. Dados internos e dados externos permanecem isolados em silos, dificultando a integração de dados, a visão unificada e a avaliação da qualidade ao longo da cadeia de valor.

A ausência de padrões para formatos, nomenclaturas e regras de negócio compromete a consistência dos dados. Ou seja, processos de integração entre sistemas legados, plataformas em nuvem e aplicações modernas tendem a amplificar problemas de qualidade quando não há padronização clara.

Esse desafio acontece especialmente em iniciativas analíticas e de IA. Dados incompletos, não representativos ou coletados de forma enviesada podem levar a análises distorcidas, decisões injustas e riscos éticos e reputacionais.

Muitas organizações sabem que têm problemas de qualidade, mas não conseguem medi-los. A ausência de indicadores padronizados dificulta comparações entre áreas, priorização de iniciativas e demonstração de valor para a liderança.

Sem uma estrutura sólida de governança de dados, cada responsabilidade fica difusa. Isso cria dados sem donos, regras pouco aplicadas e baixa accountability sobre qualidade, principalmente em ambientes distribuídos.

A inexistência de mecanismos de observabilidade de dados impede o monitoramento contínuo da qualidade. Problemas só são detectados quando já impactaram relatórios, operações ou decisões críticas.

Iniciativas de data lineage, Master Data Management (MDM), catálogos de dados e ambientes analíticos modernos adicionam camadas de complexidade técnica. Sem arquitetura adequada e ferramentas apropriadas, rastrear a origem, as transformações e o uso dos dados torna-se um grande desafio.

Medir Data Quality de forma estruturada ajuda a sair do campo da percepção.

Entenda melhor na tabela abaixo:

| Dimensão / Elemento | O que avalia | Como medir na prática | Impacto no negócio |

| Precisão | Grau de correção dos dados em relação à realidade | Comparação com fontes confiáveis, regras de validação, amostragens periódicas | Decisões mais confiáveis, redução de erros |

| Completude | Presença de todos os dados obrigatórios | % de campos obrigatórios preenchidos, análise de valores nulos | Relatórios e análises mais consistentes |

| Consistência | Coerência entre dados de diferentes sistemas | Cruzamento de bases, checagem de regras entre fontes | Menos conflitos, maior confiança nos dados |

| Atualidade (Timeliness) | Atualização dos dados no tempo adequado | SLAs de atualização, monitoramento de latência | Respostas mais rápidas e decisões no timing |

| Duplicidade | Registros redundantes da mesma entidade | Algoritmos de deduplicação, matching probabilístico | Redução de custos e visão única de clientes e ativos |

| Conformidade | Aderência a padrões, regras e regulações | Regras automatizadas, auditorias e controles | Compliance, especialmente com LGPD |

| Data profiling | Estrutura, padrões e anomalias dos dados | Análise estatística, distribuição de valores, outliers | Diagnóstico rápido de problemas de qualidade |

| Validação de dados | Correção na entrada e ao longo do fluxo | Regras de negócio, formatos e domínios válidos | Prevenção de erros na origem |

| Observabilidade de dados | Saúde contínua dos dados ao longo do pipeline | Dashboards, alertas e histórico de desvios | Detecção precoce de falhas |

| Software de Data Quality | Automação de controles e correções | Ferramentas especializadas de limpeza, validação e deduplicação | Escala e eficiência operacional |

| Governança de dados | Responsabilidade e tomada de decisão | Políticas, comitês, data owners e data stewards | Sustentabilidade da qualidade |

| Data lineage | Origem, transformações e consumo dos dados | Mapeamento ponta a ponta dos fluxos | Transparência, auditoria e confiança |

| Data catalog | Descoberta e entendimento dos ativos de dados | Metadados, classificação e documentação | Uso mais eficiente e responsável dos dados |

Alcançar boa qualidade de dados exige uma abordagem contínua, integrada e alinhada à estratégia de negócio.

Conheça os principais pilares:

Definir uma estratégia de governança de dados, com papéis, responsabilidades e apoio da liderança. Qualidade é responsabilidade de toda a organização, não apenas da TI.

Implementar MDM para centralizar, harmonizar e manter consistência das entidades-chave, como clientes, produtos e fornecedores.

Executar processos sistemáticos de limpeza de dados, incluindo deduplicação, correção de inconsistências e enriquecimento de dados com fontes confiáveis.

Definir padrões corporativos, regras de entrada e mecanismos de validação de dados desde a origem, reduzindo erros e retrabalho.

Repetir o perfilamento de dados de forma periódica para detectar degradações de qualidade e acompanhar a evolução dos indicadores.

Implementar práticas de observabilidade de dados, com dashboards, alertas e SLAs de qualidade alinhados ao negócio.

Comparar o custo da má qualidade de dados com os ganhos obtidos por iniciativas de melhoria, demonstrando ROI e priorizando investimentos.

Manter políticas vivas de governança, auditorias regulares e alinhamento com requisitos regulatórios, especialmente a LGPD, garantindo sustentabilidade e confiança ao longo do tempo.

Ambientes de BI dependem diretamente da consistência, atualidade e precisão dos dados. Quando a qualidade é baixa, relatórios deixam de refletir a realidade operacional, comprometendo decisões estratégicas. Entre os problemas causados por bad data em BI, podemos citar:

Com dados limpos, padronizados e rastreáveis, organizações conseguem consolidar métricas confiáveis, reduzir reconciliações manuais e acelerar ciclos de decisão, tornando o BI uma ferramenta efetiva de gestão e não apenas de reporte.

Outro ponto relevante de menção: a inovação de produto digital a partir da orientação por dados, como plataformas personalizadas, modelos preditivos e experiências omnichannel. Isso inclui:

Contudo, como já adiantamos, a má qualidade dos dados representa um risco em ambientes regulados. Dados imprecisos, incompletos ou desatualizados dificultam o atendimento a requisitos legais e ampliam a exposição a penalidades. Entre os principais problemas:

Por fim, podemos citar que um dos impactos mais tangíveis da qualidade dos dados está na eficiência operacional: dados inconsistentes geram retrabalho, correções manuais, falhas em processos automatizados e custos ocultos ao longo da operação.

Agora, com dados confiáveis, empresas conseguem reduzir erros em processos críticos, automatizar fluxos com maior segurança e diminuir custos operacionais associados à reconciliação de informações.

Em nosso case da Liberum Ratings, atuamos na aplicação de IA e Machine Learning para estruturar uma base de dados confiável, integrada e preparada para análises.

O trabalho envolveu:

Como resultado, a Liberum conseguiu reduzir retrabalho, aumentar a confiabilidade das análises de risco e acelerar processos decisórios, demonstrando na prática como Data Quality é um habilitador direto de eficiência e valor analítico em ambientes complexos.

Basicamente, estamos falando da importância em construir uma estratégia de qualidade de dados integrada ao roadmap corporativo de dados, preparada para sustentar crescimento, novos casos de uso analíticos e a adoção crescente de IA.

Sem esse alinhamento, a qualidade tende a se degradar à medida que volumes, fontes e complexidade aumentam.

Para sustentar essa evolução no longo prazo, a governança de dados é prioritária: para isso, um data office, a atuação do CDO e comitês multidisciplinares definem responsabilidades, priorizam iniciativas e garantem consistência nas decisões.

Esse modelo precisa ser apoiado ferramentas de software Data Quality e soluções customizadas para que equilibrem flexibilidade e aderência a cada particularidade. Ainda mais em ambientes com sistemas legados e arquiteturas híbridas.

Por fim, a qualidade dos dados só se consolida como ativo estratégico quando o valor é visível para a liderança. Isso exige transparência, com reporting contínuo de indicadores de Data Quality, visibilidade de data lineage para auditoria e confiança, e uma comunicação clara do ROI das iniciativas.

As principais tendências em dados apontam para um modelo mais automatizado, observável e integrado ao negócio.

Para isso, alertas proativos, SLAs de qualidade e histórico de desvios são recursos que permitem identificar problemas antes que eles impactem BI, operações ou modelos de IA.

A Inteligência Artificial aplicada à automatização de processos de data cleansing, deduplicação e perfilamento de dados também é uma tendência: algoritmos passam a identificar padrões, anomalias e inconsistências com mais rapidez e escala.

Esse movimento, inclusive, amplia o foco em dados mestres (MDM) e em catálogo de dados, que deixam de ser apenas ferramentas de governança e passam a ser tratados como ativos estratégicos para descoberta, confiabilidade e reuso de dados.

Paralelamente, o ambiente regulatório permanece importante. A LGPD e outras legislações reforçam a necessidade de dados corretos, rastreáveis e governados. Crescem, com isso, as parcerias entre TI e áreas de negócio, com modelos colaborativos de governança que equilibram controle, agilidade e geração de valor.

Em suma, organizações que investem em qualidade de dados reduzem riscos e criam condições reais para escalar BI, analytics e IA com segurança.

Para isso, conte com um parceiro experiente: a SoftDesign possui expertise comprovada em dados e IA, reconhecida por avaliações de mercado como o ISG Provider Lens, apoiando grandes empresas na construção de arquiteturas de dados confiáveis, governança madura e uso estratégico de Inteligência Artificial.

Para líderes que desejam avançar de forma estruturada, os próximos passos são: iniciar uma avaliação de maturidade em Data Quality, estabelecer ou fortalecer a governança de dados, pilotar soluções de software Data Quality e definir KPIs de qualidade alinhados aos objetivos do negócio.

E a SoftDesign apoia toda essa jornada por meio do serviço AI Discovery, que combina diagnóstico, direcionamento e execução para transformar dados em resultados.

Se o objetivo é evoluir a qualidade dos dados de forma sustentável, segura e orientada a valor, o momento de começar é agora: com método, governança e o parceiro certo.

Faça um diagnóstico aprofundado e conte com a gente para ajudar a implementar as melhorias que vão te levar para um próximo nível.

Tire as suas dúvidas sobre Data Quality nas perguntas e respostas abaixo.

Primeiramente, defina métricas padronizadas (precisão, completude, consistência, atualidade e conformidade) e aplique-as sobre conjuntos críticos de dados. Centralize a medição em dashboards corporativos para comparação contínua.

O investimento varia conforme maturidade, volume de dados e complexidade técnica. O ROI é calculado comparando o custo da má qualidade (retrabalho, erros, riscos regulatórios) com ganhos de eficiência e confiabilidade.

Implemente governança distribuída, com regras e métricas definidas em conjunto com o negócio. Posteriormente, use monitoramento contínuo, automação e observabilidade para melhorar a qualidade de forma incremental e segura.

Por fim, veja mais: